Bildbeschreibungen via Be my Eyes

Update ⚠️

Die Funktion steht (offenbar/bisher) nur Nutzern zur Verfügung, die sich als blind bzw. sehbehindert registriert haben.

Be My Eyes bringt blinde und sehbehinderte Menschen unter dem Aspekt der Hilfestellung, wie z.B. dem Wiederfinden eines Gegenstands, mit Sehenden zusammen. Blinde und sehehinderte Menschen können sich registrieren und Sehende dann per App um Hilfe bei allen möglichen Aufgaben bitten. Die Registrierung als Sehender ist unter Angabe der Sprachen, in denen man helfen kann, schnell erledigt. Tolle Sache, meldet euch an!

Hier soll es kurz um das Thema "Bildbeschreibungen" gehen, also um die Alternativtexte, die idealerweise jedem bedeutungstragenden Bild, das ins Netz gestellt wird, hinzugefügt werden sollten.

Wer, wie ich, bei Mastodon im Fediverse unterwegs ist weiß, dass Bildbeschreibungen ein sehr sensibles Thema sind (vorsichtig ausgedrückt). Über den Sinn muss man nicht diskutieren. Es ist ein weites Feld: Die Umsetzung ist schwierig, der Aufwand, der betrieben werden muss, um gute Infos abzuliefern, ist nicht ohne. Der Impuls des schnellen Teilens eines Fotos ist futsch, wenn man es gut machen will.

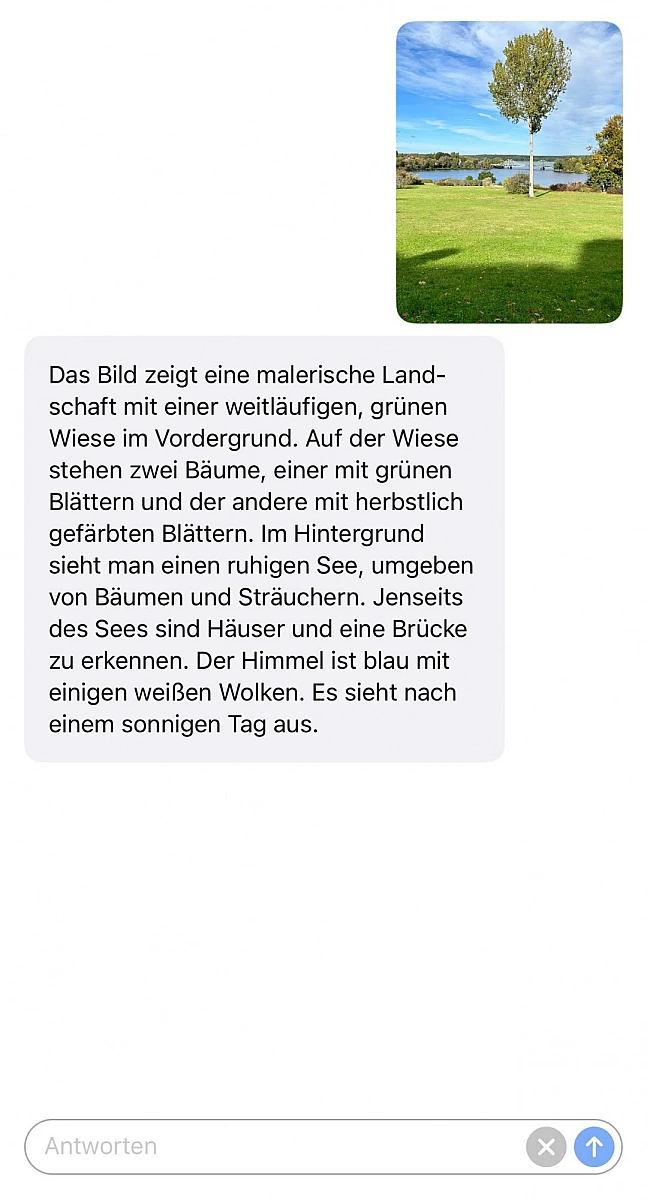

Eher durch Zufall habe ich gerade in meinem iOS-Share-Sheet die Option gefunden, mir Fotos von der "Be My Eyes"-KI beschreiben zu lassen. Dank OpenAIs GPT-4 liefert die KI eine solide und ausführliche Beschreibung dessen, was auf dem Bild zu sehen ist. Deutlich(!) besser als alles, was Apple oder Microsoft bisher nativ bzw. mit Seeing AI liefern.

Das, würde ich sagen, ist ein guter Ausgangspunkt um im Anschluss Details zu korrigieren oder eigene Hinweise einzubinden, wenn man das denn möchte. (Im Foto oben ist kein See sondern die Havel zu sehen ...)

Momentan steht das Feature iOS-Nutzern zur Verfügung, Android soll folgen. Weitere Infos: Introducing: Be My AI